Potencjalne przyspieszenie wzrostu widoczności niesie jednak ze sobą spore ryzyko, chociażby w postaci legendarnych już w branży kar ręcznych dla domeny. Czy w takim razie jest sens prowadzić tego typu działania?

Od początku istnienia wyszukiwarek internetowych właściciele różnych stron konkurowali między sobą o najwyższe pozycje w wynikach wyszukiwania. Sposoby na osiąganie tego celu na przestrzeni lat ewoluowały, jednak niezmienny pozostał podział na dwa różne podejścia do pozycjonowania, tzw. white hat, czyli rozwijanie strony w pełni zgodnie z wytycznymi Google, a także „black hat” wykorzystujące do osiągania wyników wszystkie dostępne na rynku metody, które często próbują „oszukać” algorytm, tak aby uznawał daną podstronę za bardziej wartościową, niż jest w rzeczywistości. Potencjalne przyspieszenie wzrostu widoczności niesie jednak ze sobą spore ryzyko, chociażby w postaci legendarnych już w branży kar ręcznych dla domeny. Czy w takim razie jest sens prowadzić tego typu działania?

Jak działa algorytm Google?

Algorytmy Google rozwijają się i z każdą kolejną aktualizacją dodawane są nowe parametry rankingowe, zmienia się ważność dotychczasowych lub część z nich przestaje być brana pod uwagę. Cały proces ustalania rankingu danej podstrony składa się (zgodnie z wypowiedziami pracowników Google) z ponad dwustu czynników, które oczywiście nie są w pełni upublicznione, jednak można wydzielić kilka głównych kategorii, w których się mieszczą:

- treści na stronie – od lat w branży istnieje przeświadczenie, że „content is king” i to właśnie merytoryka tekstów danej podstrony jest jej główną zaletą. Nie ma w tym zresztą nic dziwnego – Google jest wyszukiwarką tekstową i tekst jest w stanie zrozumieć najlepiej;

- autorytet strony – czyli szeroko rozumiany profil zewnętrzny domeny. Budują go przede wszystkim referencje i linkowania z innych serwisów, a także historia danego portalu;

- stan techniczny – wpływ na ranking ma również to, czy strona nie zawiera błędów, jest zawsze łatwo dostępna dla użytkownika, a jej prędkość ładowania jest możliwie jak największa. Google dąży do tego, by odczucia osoby odwiedzającej serwisy internetowe były jak najlepsze – a zadbanie o prawidłowe działanie techniczne strony znacząco wpływa na komfort korzystania z niej.

Powyższe zestawienie to duże uproszczenie, jednak dość dobrze obrazuje trzy aspekty, w których należy dążyć do doskonalenia strony internetowej.

Krótka historia pozycjonerów w czarnej czapce

Zanim przejdziemy do obecnych „sztuczek”, warto rzucić okiem na rys historyczny podejścia „black hat”. Jak łatwo się domyślić, w pierwszych latach istnienia wyszukiwarki Google o wiele łatwiej było obejść zasady, „zhakować” algorytm i zdobyć topkę. Jak to osiągano?

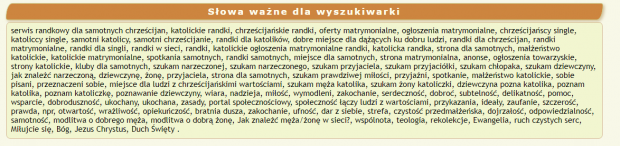

Keyword stuffing

Jedną z pierwszych technik był tzw. keyword stuffing – czyli krótko mówiąc, spamowanie słowami kluczowymi na danej podstronie na wszystkie możliwe sposoby. Wykorzystywano do tego różne, często niewidoczne na pierwszy rzut oka elementy jak np. kod strony (w szczególności obszar meta keywords, który obecnie jest już niewykorzystywany) czy wypisywanie po przecinku wszystkich słów kluczowych, na które pozycjonujemy dany adres (czy to na samym dole strony, czy małą, białą czcionką na białym tle). Użytkownik nie widzi różnicy, a robot indeksujący czyta frazę za frazą, sądząc błędnie, że strona jest wartościowa. Proste i skuteczne – tyle że nie daje realnego obrazu strony i tego, jaką wartość może mieć dla użytkownika. Naturalne jest więc, że Google dość szybko zaczęło z tym walczyć i obecnie keyword stuffing jest niepożądany – jednak pozostałości tej epoki pozycjonowania można na niektórych stronach dostrzec do dziś.

Źródło: https://zapisanisobie.pl/

Obecnie popularna jest nieco inna, mniej agresywna forma keyword stuffingu – sztuczne umieszczanie konkretnego słowa kluczowego w tekście, wiele razy. Tekst, choć nienaturalny, wnosi przynajmniej jakąś wartość dla użytkownika, a przy odpowiednim podejściu i optymalizacji można tę technikę wykorzystać do przygotowania tekstów zarówno merytorycznych, jak i korzystnie wpływających na ranking strony. Kluczem jest tutaj „nie przedobrzyć”.

Źródło: https://developers.google.com/search/docs/advanced/guidelines/irrelevant-keywords

Agresywny link building

Profil linkowy strony jest jednym z głównych wyznaczników jej autorytetu, dlatego też od początku istnienia SEO starano się znaleźć najlepsze sposoby na jego rozwój. Przez długi czas znaczenie miała przede wszystkim jak największa liczba linków, a jakiekolwiek wycenianie ich jakości schodziło na dalszy plan. Wtedy też zaczęły królować SWL-e (Systemy Wymiany Linków), które, jak sama nazwa wskazuje, ułatwiały dużej liczbie witryn wzajemne linkowanie. W efekcie ich profil linkowy zyskiwał, a co za tym idzie, strona osiągała wyższe pozycje w wynikach wyszukiwania.

Taki mechanizm działał zaskakująco długo i przynosił zdumiewające efekty, miał jednak jeden znaczący problem – wysoki poziom ryzyka. Ze względu na to, że wszystkie strony w danej grupie wymiany linków były ze sobą bezpośrednio powiązane, bardzo łatwo było je zidentyfikować – a gdy jedna z nich dostawała karę, ciągnęła za sobą również pozostałe. Obecnie algorytmy rankingowe są na tyle rozwinięte, że z SWL-i praktycznie w całości zrezygnowano.

W ocenie Google SWL-e to tylko jeden z wielu sposobów na nieprawidłowo rozwijany profil linkowy. Popularne stały się także spamerskie liczby linków z katalogów, for czy komentarzy we wpisach blogowych (szczególnie jeśli dana podstrona nie jest moderowana). Z czasem linkowanie przybrało na jakości i przestano myśleć w kategorii „im więcej, tym lepiej” – i taki stan rzeczy utrzymuje się do dzisiaj. Najpopularniejsze obecnie są tematyczne publikacje zewnętrzne promujące stronę, zawierające link do określonej strony.

I chociaż według wypowiedzi Johna Muellera Google jest w stanie odróżnić naturalne linki od kupowanych – i te drugie nie będą miały żadnego efektu – trudno jest oprzeć się wrażeniu, że pozycjonowanie bez pozyskiwania dodatkowych linków jest praktycznie niemożliwe.

Źródło: https://www.searchenginejournal.com/john-mueller-answers-about-link-building/410367/

Pozostaje pytanie: jak poprawnie prowadzić link building? Nie ma jednej, konkretnej odpowiedzi, jednak najważniejsze to zachować maksymalną naturalność profilu domeny. Należy bardziej koncentrować się na linkach brandowych, publikowanych w unikalnych artykułach, które będą prowadzić do strony głównej. Nie można jednak zapomnieć o linkowaniu z mniej jakościowych, jednak popularnych miejsc, jak fora czy komentarze blogowe, w celu zachowania proporcji, które można nazwać „rzeczywistymi”.

Cloaking

Co zrobić w sytuacji, gdy z jednej strony chcemy, aby strona była jak najbogatsza w treści, zdjęcia, dodatkowe rozwiązania, które jednak bardzo mocno zwalniają prędkość jej działania i obniżają inne parametry techniczne? W odpowiedzi na to pytanie powstała idea cloakingu, czyli przedstawiania dwóch różnych wersji strony dla użytkownika i robotów indeksujących. Ta pierwsza byłaby wersją realną, widoczną dla użytkowników (i często ładującą się naprawdę długo), podczas gdy roboty przekierowywane byłyby na drugą, praktycznie pustą stronę. Może „pustą” to zbyt duże uproszczenie, nadal znajdowałyby się na niej teksty, linki, menu itd. jednak nie zawierałaby żadnych zdjęć, JavaScriptu czy CSS-ów – i osiągnęłaby dzięki temu praktycznie maksymalne wyniki w testach prędkości.

Cloaking obecnie nie jest tak popularny, jak kiedyś – głównie dlatego, że Google znalazło sposoby na wykrywanie takich opcji i grozi to karą dla strony. Oprócz tego było to rozwiązanie bardzo nieprzyjazne dla użytkownika, gdyż często zapominano o jakiejkolwiek optymalizacji strony (przecież Google i tak jej nie zobaczy), co drastycznie zwiększało współczynnik odrzuceń. Mimo to dobrze przemyślany cloaking nadal może przynosić pozytywne efekty, chociaż obecnie jest raczej wykorzystywany do ukrywania albo eksponowania pojedynczych elementów strony, a nie jej całości. Przykładem mogłoby być umieszczanie tekstów na stronie – w wersji dla robotów na samym jej szczycie, w wersji dla użytkowników pod listą produktów.

Czy podział na white hat i black hat SEO ma jeszcze sens?

Pozycjonowanie przez lata zmieniło się tak bardzo, że warto się zastanowić, czy taki zero-jedynkowy podział ma jeszcze rację bytu. Wielu pozycjonerów szczyci się byciem „white hat” i działaniem w pełni zgodnie z wytycznymi Google – jednak czy na pewno?

Czy nie jest przypadkiem tak, że każda optymalizacja strony pod określone słowa kluczowe jest taką małą, lepiej przemyślaną formą keyword stuffingu?

Czy celem zamawiania artykułu sponsorowanego jest zwiększenie jakości treści w Internecie, czy jednak sztuczna poprawa profilu linkowego?

Prawda jest taka, że te dwa terminy – black hat i white hat – są już ze sobą tak zbieżne i wymieszane, że trudno jest je momentami rozróżnić. Z tego powodu powstał nowy termin, który chyba najlepiej oddaje obraz tej sytuacji – grey hat SEO.

Bo świat nie jest tylko czarny i biały, a czerpanie tego, co najlepsze z obu tych technik daje zdecydowanie najlepsze efekty.

Słowniczek:

- Keyword stuffing – spam za pomocą słów kluczowych. Na konkretnej podstronie były umieszczane wszystkie słowa kluczowe, na które była pozycjonowana strona, jednak nie były one widoczne dla użytkowników, a tylko dla robotów indeksujących.

- Meta keywords – to metatag w kodzie HTML strony, który miał określać tematykę witryny, aktualnie nie są brane pod uwagę podczas indeksowania strony przez Google.

Kamil Górecki International SEO Specialist | iCEA Group

Rozpoczął swoją karierę w SEO ponad dwa lata temu. Na co dzień, jako International SEO Specialist, przygotowuje i wdraża w życie długoterminowe strategie rozwoju dla stron międzynarodowych. Po pracy gra w planszówki, RPGi, chodzi do kina i gra w siatkówkę.

Pobierz ebook "Ebook o social media marketingu w 2025 roku i agencjach w nim się specjalizujących"

Zaloguj się, a jeśli nie masz jeszcze konta w Interaktywnie.com - możesz się zarejestrować albo zalogować przez Facebooka.

Alpaki często mylone są z lamami. Nas nie pomylisz z nikim innym. To my …

Zobacz profil w katalogu firm

»

W 1999 roku stworzyliśmy jedną z pierwszych firm hostingowych w Polsce. Od tego czasu …

Zobacz profil w katalogu firm

»

Projektujemy i wdrażamy strony internetowe - m.in. sklepy, landing page, firmowe. Świadczymy usługi związane …

Zobacz profil w katalogu firm

»

Pozycjonujemy się jako alternatywa dla agencji sieciowych, oferując konkurencyjną jakość, niższe koszty i większą …

Zobacz profil w katalogu firm

»

Skorzystaj z kodu rabatowego redakcji Interaktywnie.com i zarejestruj taniej w Nazwa.pl swoją domenę. Aby …

Zobacz profil w katalogu firm

»

Pomagamy markom odnosić sukces w Internecie. Specjalizujemy się w pozycjonowaniu stron, performance marketingu, social …

Zobacz profil w katalogu firm

»

Interaktywnie.com jako partner Cyber_Folks, jednego z wiodących dostawców rozwiań hostingowych w Polsce może zaoferować …

Zobacz profil w katalogu firm

»