Na początek trzeba przeanalizować dostępność witryny dla Googlebota.

Search Console (wcześniej znane jako Google Webmaster Tools) to zestaw narzędzi pomagających zrozumieć, jak Google interpretuje i ocenia naszą stronę internetową. To również miejsce, gdzie możemy wchodzić w bezpośrednie interakcje z liderem na rynku wyszukiwarek, wpływając na sposób indeksowania podstron w serwisie czy korygując błędy rzutujące na efektywności działań SEO. Jakie funkcje Search Console są najważniejsze dla pozycjonowania witryn w wyszukiwarce Google?

Na początku 2018 roku Google zaprezentowało nową wersję Search Console i rozpoczęło stopniowe przenoszenie starych funkcjonalności do nowej wersji. Oprócz zmian w layoucie i w sposobie prezentacji danych, odświeżona wersja narzędzia dla webmasterów dała użytkownikom większe możliwości analizy danych dotyczących ruchu organicznego do ich witryn.

Początkowo nowa Search Console oferowała jedynie część narzędzi znanych dotychczas webmasterom. W kolejnych miesiącach stopniowo przenoszone są kolejne funkcjonalności, zaś stara wersja narzędzia wciąż jest dostępna równolegle i możemy z niej swobodnie korzystać. Z punktu widzenia osób zajmujących się pozycjonowaniem stron w wyszukiwarkach najważniejsze funkcjonalności Search Console pozostają jednak te same i pomagają w tym samym: weryfikacji skuteczności prowadzonych działań, monitorowaniu stanu indeksowania oraz ocenie dostępności serwisu dla Googlebota.

W poradniku przedstawimy Wam cztery krytyczne dla pozycjonowania obszary oraz związane z nimi funkcje Search Console, które mogą pomóc w poprawie widoczności organicznej witryny. Pierwsza część artykułu dotyczy analizowania dostępności witryny dla Googlebota.

Weryfikacja dostępu Googlebota do witryny

Podstawowym kryterium, które musi spełnić nasza witryna, aby pojawiać się w wynikach wyszukiwania, jest jej dostępność dla bota Google oraz zakres crawlowania i indeksowania witryny. Jeśli Googlebot ma problem z dostępem do strony, wówczas wszelkie działania off-site nie będą miały żadnego przełożenia na rankingi. Strona nie zostanie uwzględniona w wynikach wyszukiwania, gdyż bot Google nie jest w stanie jej przeanalizować i prawidłowo ocenić. W tym obszarze Search Console dostarcza wiele przydatnych narzędzi pomagających zweryfikować stan indeksowania oraz dostępności serwisu dla bota wyszukiwarki.

Mapa witryny

Mapa witryny jest to uporządkowany dokument, najczęściej w formacie .xml, który zawiera odnośniki do najważniejszych podstron naszego serwisu. Dzięki niemu Googlebot otrzymuje informacje dotyczące rodzaju zasobów, ich rangi, a także struktury witryny, dzięki czemu proces crawlowania i klasyfikowania podstron jest łatwiejszy.

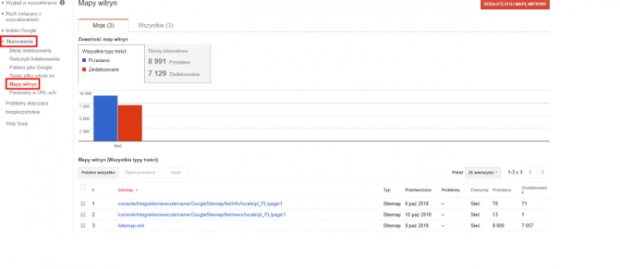

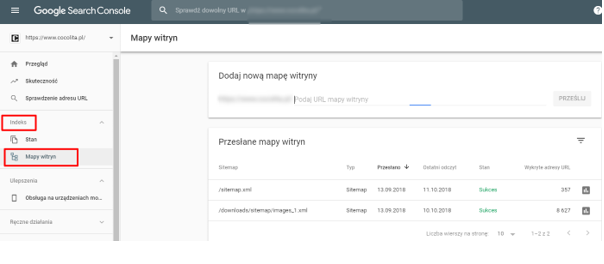

W sekcji Mapy witryn Search Console możemy wprowadzić ręcznie link do sitemapy (lub całej listy map) znajdującej się w naszym serwisie.

Domyślnym adresem dla tego zasobu jest nazwadomeny.pl/sitemap.xml, jednak w przypadku części skryptów mapy witryn generowane są pod zupełnie innymi adresami (np. skrypt Shoper domyślnie generuje mapy witryn dla różnych zasobów pod adresem nazwadomeny.pl/console/integration/execute/name/GoogleSitemap/list).

Dzięki sekcji Mapy witryn w Search Console możemy sprawdzić, ile ze zgłoszonych w sitemapie elementów (np. grafik lub podstron HTML) zostało zaindeksowanych przez Google, a także ile z nich zostało pominiętych i dlaczego.

Często zgłoszone w mapie witryny adresy są z różnych względów niedostępne dla Googlebota lub stoją w konflikcie z innymi wytycznymi dotyczącymi indeksowania (np. dostęp do nich jest zablokowany w robots.txt, w nagłówku występuje tag “noindex”, zgłoszona podstrona zwraca błąd 404 lub jest przekierowywana na inny adres). Dzięki weryfikacji mapy witryny w Search Console mamy możliwość dokładnego sprawdzenia poprawności generowania naszej mapy witryny, a także możemy łatwo zidentyfikować podstrony, które zostały pominięte przy indeksowaniu.

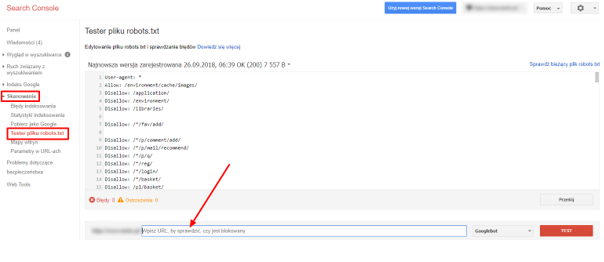

Tester pliku robots.txt

Plik robots.txt zawiera dyrektywy dla botów internetowych określające zakres ich dostępu do naszego serwisu. Dzięki wytycznym w pliku jesteśmy w stanie wykluczyć z crawlowania część zasobów, które nie mają większej wartości pod kątem pozycjonowania, lub np. powodują duplikację treści w serwisie. Komenda Allow: dopuszcza boty do określonych zasobów, zaś komenda Disallow: wyklucza dostęp botów do określonych podstron/zasobów strony.

W Search Console w sekcji Skanowanie ->Tester pliku robots.txt możemy zweryfikować poprawność budowy pliku robots.txt, a także sprawdzić czy dana podstrona jest dostępna dla Googlebota czy też dostęp do niej jest blokowany przez odpowiednią dyrektywę w pliku robots.txt.

Uwaga! Wytyczne w pliku robots.txt w niektórych sytuacjach mogą być ignorowane przez boty, dlatego najlepszym sposobem na wykluczenie strony z indeksu jest wprowadzenie znaczników <meta name=”robots” content=”noindex”> w sekcji <head> danej podstrony.

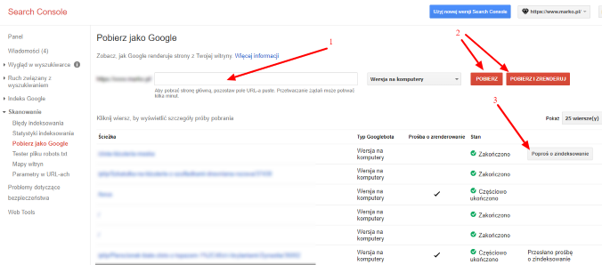

Dodawanie adresu URL do indeksu

Jedną z przydatnych funkcji Search Console jest możliwość ręcznego dodania nowej podstrony do indeksu Google. Jeśli zależy nam na szybkiej indeksacji nowej podstrony, powinniśmy skorzystać właśnie z tej opcji. Aby to zrobić w starej wersji Search Console powinniśmy wejść w sekcję Indeks -> Pobierz jako Google, następnie wprowadzić adres podstrony, potwierdzić przyciskiem Pobierz lub Pobierz i zrenderuj, a następnie kliknąć pole Poproś o zindeksowanie:

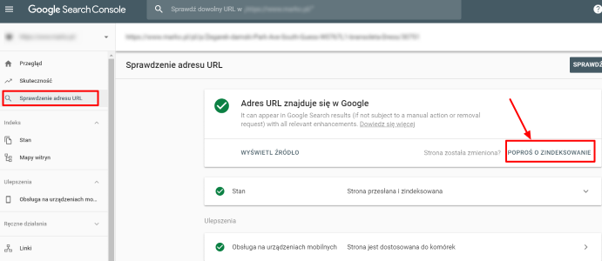

Ten sam proces możemy wykonać również w nowej wersji Search Console - w tym celu wybrany adres należy wprowadzić w sekcji Sprawdzanie adresu URL i w razie gdy adres nie został jeszcze zaindeksowany, wybrać pole Poproś o zindeksowanie:

Funkcja ta jest szczególnie przydatna wtedy, gdy zależy nam na szybkiej indeksacji nowej podstrony, np. w przypadku premiery nowego produktu, kiedy występują już pierwsze zapytania na frazy produktowe z nim związane, zaś wyniki w Google nie są jeszcze adekwatne i jest szansa, że nasza nowa podstrona szybko pojawi się na pierwszej stronie wyników.

Usuwanie adresu URL z indeksu

Podobnie jak możemy dodać ręcznie URL do indeksu, tak również jedna z funkcjonalności Search Console pozwala usunąć ręcznie wybraną podstronę z indeksu Google.

Uwaga! Opcja usunięcia adresu z indeksu jest opcją tymczasową - po pewnym czasie Google może ponownie zaindeksować usuniętą podstronę, dlatego jeżeli chcemy trwale usunąć ją z indeksu, należy dodatkowo wprowadzić tag “noindex” w sekcji <head>. Z opcji należy korzystać tylko i wyłącznie w przypadku, kiedy chcemy, by żaden użytkownik nie trafiał na daną podstronę z wyszukiwarki Google.

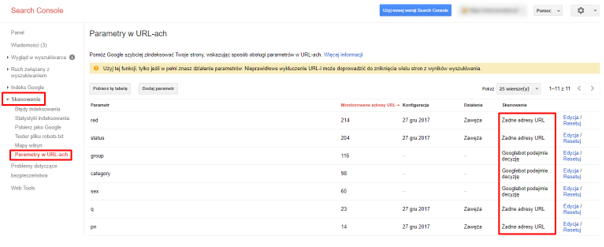

Parametry w URL’ach

Częstym problemem w przypadku sklepów internetowych jest indeksowanie podstron z parametrami, które w dużym stopniu są duplikatami i prowadzą również do kanibalizacji słów kluczowych (podstrony z parametrami mają te same meta tagi co wyjściowe podstrony, np. kategorie sprzed filtrowania).

W Search Console możemy ręcznie określić, jak Googlebot powinien interpretować dany parametr pojawiający się w naszym serwisie, a także czy podstrony zawierające go powinny być skanowane i indeksowane, czy też nie (domyślnie decyzję podejmuje tutaj Googlebot). Pomaga to w ograniczeniu indeksacji duplikatów podstron, ograniczeniu kanibalizacji słów kluczowych, a także pozwala zaoszczędzić budżet crawlowania.

Aby sprawdzić i określić parametry występujące w naszej witrynie należy wejść w sekcję Skanowanie, a następnie Parametry w URL’ach:

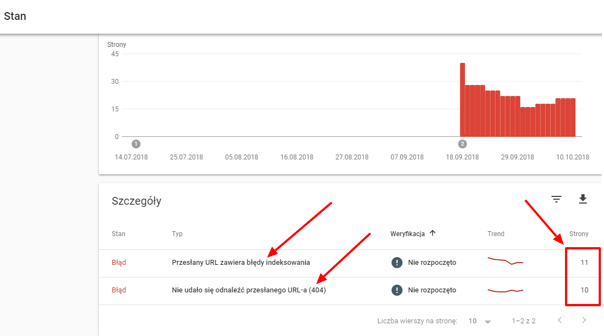

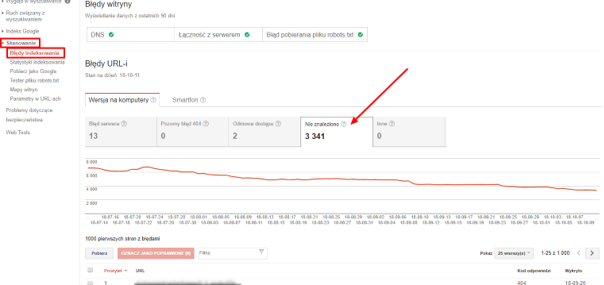

Błędy indeksowania

Jedną z często wykorzystywanych w SEO funkcji Search Console jest analiza błędów 404 (niedostępne podstrony w serwisie do których wcześniej Googlebot miał dostęp). W sekcji Skanowanie -> Błędy indeksowania znajdziemy listę adresów stron zwracających błąd 404.

Na liście często znajdują się historyczne błędy 404, więc przed ich przekierowaniem należy sprawdzić, czy wciąż są niedostępne - w tym celu trzeba wyeksportować listę URL’i i sprawdzić ją w wybranym narzędziu weryfikującym bieżący status podstron (np. Screaming Frog). Po wprowadzeniu przekierowań z niedziałających adresów możemy w tej samej sekcji zasygnalizować Google, że problem związany z niedostępnością danej podstrony został już rozwiązany.

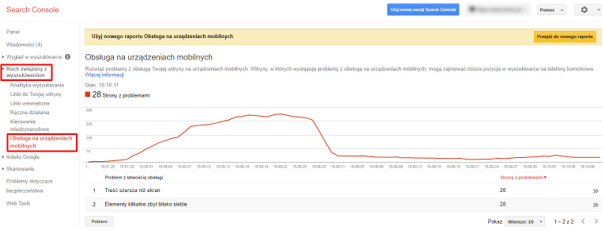

Optymalizacja witryny pod kątem urządzeń mobilnych

Inną ważną funkcją Search Console związaną ze skanowaniem serwisów internetowych jest weryfikacja optymalizacji strony pod urządzenia mobilne. W tym celu w starej wersji Search Console należy wybrać sekcję Ruch związany z wyszukiwaniem -> Obsługa na urządzeniach mobilnych:

Raport w tej sekcji dostarczy nam informacji na temat głównych problemów związanych z dostosowaniem naszej strony do urządzeń z małym ekranem.

|

W kolejnych częściach poradnika omówione zostaną kolejne funkcjonalności Search Console związane z:

|

Pobierz ebook "Jak reklamować firmę w Google w 2024 roku. Poradnik dla przedsiębiorców i marketerów"

Zaloguj się, a jeśli nie masz jeszcze konta w Interaktywnie.com - możesz się zarejestrować albo zalogować przez Facebooka.

1stplace.pl to profesjonalna agencja SEO/SEM, specjalizująca się w szeroko pojętym marketingu internetowym. Firma oferuje …

Zobacz profil w katalogu firm

»

Pomagamy markom odnosić sukces w Internecie. Specjalizujemy się w pozycjonowaniu stron, performance marketingu, social …

Zobacz profil w katalogu firm

»

Projektujemy i wdrażamy strony internetowe - m.in. sklepy, landing page, firmowe. Świadczymy usługi związane …

Zobacz profil w katalogu firm

»

W 1999 roku stworzyliśmy jedną z pierwszych firm hostingowych w Polsce. Od tego czasu …

Zobacz profil w katalogu firm

»

Pozycjonujemy się jako alternatywa dla agencji sieciowych, oferując konkurencyjną jakość, niższe koszty i większą …

Zobacz profil w katalogu firm

»

Marcin Olszewski, Starszy Specjalista SEO w Sempai

Marcin Olszewski, Starszy Specjalista SEO w Sempai