Kara od Google może słono kosztować...

Google, choć nie zdradza wszystkich tajemnic algorytmu swojej wyszukiwarki, nie szczędzi deweloperom i marketerom wytycznych, które pozwalają im tworzyć strony przyjazne zarówno botom, jak i użytkownikom. Próby przechytrzenia algorytmów celem sztucznego wywindowania witryny w wynikach wyszukiwania mogą być powodem nałożenia kary.

A kara od Google może słono kosztować, o czym przekonały się niegdysiejsze potęgi polskiego rynku porównywarek cenowych, którym (a przynajmniej nie wszystkim) po tym podnieść.

- Jedną z najbardziej dotkliwych i głośnych kar, które miały miejsce w polskim internecie, było ukaranie w tym samym czasie trzech największych porównywarek cen – Ceneo, Skąpca i Nokauta. Akcja miała miejsce w 2012 roku, kiedy to Google ukarał serwisy (oraz kilka innych, dużych brandów) za korzystanie z systemów wymiany linków. Strony przez ponad miesiąc praktycznie nie były dostępne w bezpłatnych wynikach wyszukiwania, co z pewnością mocno odbiło się na ich ruchu - mówi Maciej Brożonowicz, COO w MBridge – Marketing Experts, przypominając jednocześnie, że na europejskim rynku też nie wszyscy grali według zasad giganta.

- Innym ciekawym przykładem, tym razem z rynku globalnego była kara nałożona na oficjalną, niemiecką stronę marki BMW w 2006 r. W wyniku cloakingu (tj. pokazywania innej treści użytkownikom, a innej robotom Google), motoryzacyjny gigant został usunięty z wyników wyszukiwania na 3 dni - przypomina ekspert.

Im głębiej zajrzymy w historię SEO w Polsce i na świecie, tym więcej znajdziemy przykładów dotyczących cloakingu. Ostatnie lata to w zasadzie wyłącznie ręczne kary za wykorzystywanie systemów wymiany linków.

Warto zwrócić uwagę także na zjawisko usuwania z indeksu Google serwisów, które padły ofiarą hakerów. Google po wykryciu, że dana strona została zhakowana i znajduje się na niej wirus może w trybie natychmiastowym wykluczyć ją z wyników. Jednak nie zawsze mechanizmy te działają w 100% poprawnie.

Pod koniec listopada podobny system został niesłusznie zastosowany w przypadku Search Engine Land. W efekcie jedna z największych stron o marketingu w wyszukiwarkach została całkowicie usunięta na kilka godzin z wyników wyszukiwania. Szybka reakcja serwisu pomogła cofnąć ten błąd i witryna ponownie pojawiła się w Google.

- Maciej Brożonowicz – COO w MBridge – Marketing Experts.

Black Hat SEO, czyli co?

- Pozycjonowanie organiczne możemy podzielić na dwa przeciwległe bieguny: działania zgodne ze wskazówkami dla webmasterów od Google oraz tzw. Black-Hat SEO, które długoterminowo może przynieść zdecydowanie więcej zagrożeń aniżeli zysków - mówi Maciej Kapuściński, Traffic & Web Development Director w agencji Result Media. - Użytkownicy korzystają z wyszukiwarki aby znaleźć najbardziej rzetelne odpowiedzi. Brak odpowiedniej kontroli nad wynikami mógłby spowodować masowy odpływ Użytkowników od Google, na co gigant z Mountain View nie mógłby sobie pozwolić.

Przykładów niedozwolonych praktyk można wymieniać wiele, jednak główne z nich to:

- generowanie automatycznych treści,

- korzystanie z systemów wymiany linków (SWL),

- maskowanie treści (tzw. cloaking, czyli udostępnianie robotom wyszukiwarek innej treści niż treść skierowana do użytkowników,),

- ukrywanie treści

- czy też tworzenie stron internetowych zawierających złośliwe oprogramowanie.

Skala ryzyka jest równoważna do skali naruszeń. Przykładami kar, które witryna może otrzymać to filtr, zmniejszenie zaufania wobec strony, obniżenie pozycji w SERP, oraz ban – czyli usunięcie z indeksu Google.

O tym jak sprawdzić, czy i jaki filtr otrzymaliśmy od Google na kolejnej stronie pisze Mariusz Waszkiewicz, starszy specjalista SEO w agencji Sempai

AUTOR: Mariusz Waszkiewicz, starszy specjalista SEO w agencji Sempai

Należy pamiętać, że każda strona, aby stać się zaufaną w oczach samego Google, czyli zajmować wysokie pozycje w wyszukiwarce, potrzebuje czasu. W zależności od branży i konkurencji może to być kilka miesięcy, a nawet i rok. W tym czasie roboty wyszukiwarki bardzo uważnie przyglądają się takim stronom, weryfikując, czy przestrzegają wskazówek dotyczących treści, jak i jakości, m.in. skąd pozyskują linki czy tworzą treści z myślą o użytkowników.

A przecież nie każdy właściciel sklepu, bloga czy nawet zwykłej wizytówki firmowej chce czekać na pierwsze efekty pozycjonowania tak długo i niekiedy niestety idzie drogą na skróty.

Typy nakładanych filtrów

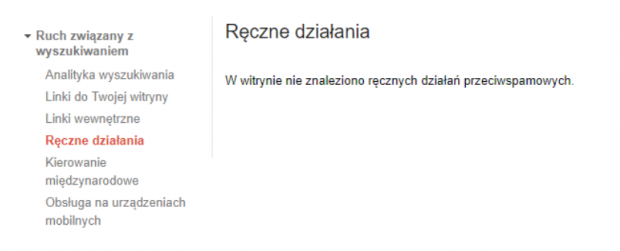

Można je podzielić na dwa typy: ręczne i automatyczne. Ten pierwszy, jak sama nazwa wskazuje, charakteryzuje się ręcznym nałożeniem kary przez pracownika Google. Aby sprawdzić, czy nasza witryna narusza wskazówki Google, należy zalogować się do Search Console, a następnie wejść w zakładkę “Ruch związany z wyszukiwaniem -> Działania ręczne”:

Drugim typem kary, w ramach której Google może obniżyć widoczność witryny w wyszukiwarce, są filtry algorytmiczne (automatyczne) wdrażane przy okazji aktualizacji algorytmu, np. Panda, Pingwin, Phantom.

Dużo korzystniejszą (jeśli można użyć takiego słowa) jest kara ręczna, gdyż po naprawieniu błędów, których ona dotyczy, mamy szansę w miarę szybko powrócić na zbliżone pozycje sprzed bana. W przypadku aktualizacji automatycznej nie jest to takie proste i oczywiste, gdyż problem może być bardziej złożony, a przywrócenie strony na wysokie pozycje będzie możliwe dopiero przy kolejnej aktualizacji algorytmu.

Typy powiadomień

Do najczęściej spotykanych powiadomień ręcznych działań w Search Console można zaliczyć:

Witryna zaatakowana przez hakerów

Jest powiadomieniem związanym z brakiem bezpieczeństwem strony. W przypadku braku aktualizacji systemu CMS (z ang. Content Management System), nieaktualnych modułów/wtyczek lub innych luk w systemie hakerzy przejmują kontrolę nad stroną i tworzą przekierowania do stron afiliacyjnych czy też generują dodatkowe podstrony z automatycznie generowaną treścią w obrębie zhakowanych domen.

Spam tworzony przez użytkowników

Powiadomienie to w głównej mierze tyczy się for i blogów z aktywnymi użytkownikami, którzy w specjalnie dedykowanych do tego miejscach zamieszczają linki do swoich stron z tekstem kotwicy/anchoru, na który się pozycjonują, np.: “Tanie pożyczki, Viagra, Kasyno, Bukmacher, Tanie wakacje itp”.

Spamerskie darmowe hosty

Jeśli Twoja strona znajduje się w podejrzanym sąsiedztwie innych stron łamiących wytyczne ze strony Google, taki host zostaje z góry oflagowany. Jeśli chcemy poznać “naszych sąsiadów”, wystarczy skorzystać np. z narzędzia. W przypadku nieodpowiedniego towarzystwa należy rozważyć zmianę hostingu ;)

Nienaturalne linki do Twojej witryny

Jest niewątpliwie najczęściej spotykanym powiadomieniem w świecie SEO. Google informuje webmastera o wykryciu nienaturalnych linków, których celem jest manipulowanie rankingiem.

Zwykle jest ono skutkiem agresywnego linkowania, czyli szybkiego przyrostu linków w bardzo krótkim czasie ze stron o niskiej jakości niepowiązanych tematycznie ze stroną linkowaną (min. katalogi stron, precle, linki z sygnaturek, Systemy wymiany linków tzw. SWL - pamiętny filtr z 2012 roku, który najbardziej dotknął porównywarki cen, m.in. Ceneo, Nokaut).

W takim przypadku należy pozbyć się linków niskiej jakości (poprzez kontakt z właścicielem portalu lub samodzielnie). Natomiast w przypadku braku możliwości usunięcia linków należy zrzec się ich przy pomocy narzędzia “Google Disavow Tools”. W tym celu należy przygotować odpowiedni plik .txt według tych wytycznych.

Czysty spam

Jeśli Twoja witryna w 100% posiada skopiowane treści z innych witryn lub też generowane są bezużyteczne treści, które są zlepkiem słów zawierające tylko słowa kluczowe możesz mieć pewność że taka strona nawet nie zaindeksuje się w wyszukiwarce.

Ukryty tekst lub upychanie słów kluczowych

Strony posiadające tekst w kolorze tła, a także zawierające ciągi powtórzonych słów w tekście czy w tagach title narażone są również na filtr ręczny. Więcej o tych i innych powiadomieniach ręcznych przeczytasz na stronie.

SEO dziś

Wśród najczęściej stosowanych jeszcze nie tak dawno technik z tzw. Czarnego Kapelusza można było zaliczyć upychanie słów kluczowych czy ukrywanie tekstu na stronie. Prawdziwą plagą było masowe pozyskiwanie linków z niskiej jakości źródeł z wykorzystaniem automatów czy SWL-i. Wygrywał ten, kto pozyskał więcej odnośników. Liczyła się ilość a nie jakość.

Aktualnie w dobie inteligentnych algorytmów Google i ich częstych aktualizacji stosowanie metod sprzed 2012 roku, kiedy to liczyła się jedynie ilość linków prowadzących do witryny, staje się być niezasadne. Co więcej, naraża witrynę na poważne konsekwencje ze strony Google, łącznie z usunięciem strony z wyszukiwarki.

Na szczęście świadomość liczących się graczy na rynku jest dziś bardzo duża. Widać to chociażby po poczynionych inwestycjach. Na sukces jednego projektu pracuje cały sztab ludzi. Zaniedbanie choćby najmniejszych spraw, np. brak moderacji na forum czy brak monitoringu przychodzących backlinków skutkować może milionowymi stratami w skali roku.

Pobierz ebook "E-book: E-commerce w 2026 roku"

Zaloguj się, a jeśli nie masz jeszcze konta w Interaktywnie.com - możesz się zarejestrować albo zalogować przez Facebooka.

Projektujemy i wdrażamy strony internetowe - m.in. sklepy, landing page, firmowe. Świadczymy usługi związane …

Zobacz profil w katalogu firm

»

Pozycjonujemy się jako alternatywa dla agencji sieciowych, oferując konkurencyjną jakość, niższe koszty i większą …

Zobacz profil w katalogu firm

»

Skorzystaj z kodu rabatowego redakcji Interaktywnie.com i zarejestruj taniej w Nazwa.pl swoją domenę. Aby …

Zobacz profil w katalogu firm

»

Interaktywnie.com jako partner Cyber_Folks, jednego z wiodących dostawców rozwiań hostingowych w Polsce może zaoferować …

Zobacz profil w katalogu firm

»

Alpaki często mylone są z lamami. Nas nie pomylisz z nikim innym. To my …

Zobacz profil w katalogu firm

»

W 1999 roku stworzyliśmy jedną z pierwszych firm hostingowych w Polsce. Od tego czasu …

Zobacz profil w katalogu firm

»

Niełatwe jest życie pozycjonera ;)<br /><br /> Tutaj dowiedziałem się o czymś nowym - zrzekaniu się linków przychodzących. Dzięki!

Dziękuję za cenne informacje :)